Искусственный интеллект превращается в расиста и женоненавистника. Как машина унаследовала грехи людей

Искусственный интеллект из образца непредвзятости превращается в хранилище всех человеческих недостатков

Роботы расисты и женоненавистники

Искусственный интеллект учится расизму и женоненавистничеству, считают ученые.

Весной 2014 года Бриша Борден не успевала забрать свою крестницу из школы. 18-летняя девушка заметила на улице непристегнутый синий велосипед и серебряный самокат. Борден и её подруга схватили чужие велосипед и самокат и поехали забирать ребенка.

Однако девушки поняли, что слишком велики для детского велосипеда и самоката, так как все это принадлежало 6-летнему ребенку. Борден и ее подруга бросили детские средства передвижения и решили добраться до школы самостоятельно.

Но было слишком поздно - сосед, который был свидетелем кражи, вызвал полицию. Девушки были арестованы и обвинялись в мелкой краже за предметы общей стоимостью в $80.

Аналогичное преступление произошло позже летом. 41-летний Вернон Пратер был арестован за кражу в магазине на сумму $86,35. Это не первое преступление Пратера. Ранее он был осужден за вооруженное ограбление. За это мужчина уже отсидел 5 лет в тюрьме.

Однако, когда дела Борден и Пратера рассматривались в суде, то случилось что-то странное. Во многих тюрьмах и судебных системах Америки внедрили программы искусственного интеллекта для обработки данных — “Compas”. ИИ выдал прогноз, что Борден вероятнее всего совершит еще преступление в будущем. А вот Пратер, по мнению машины, не представлял угрозы обществу в будущем. Дело в том, что 18-летняя девушка Бриша Борден является афроамериканкой, а рецидивист Вернон Пратер — белый мужчина.

Прогноз машины не сбылся. После истории с велосипедами Борден больше не нарушала закон. А Пратер заработал себе новый восьмилетний тюремный срок за проникновение на склад и кражи электроники стоимостью в тысячи долларов.

Аналогичная история произошла с Диланом Фаджетом и Бернардом Паркером. Оба мужчин (в разное время) были арестованы за хранение кокаина и марихуаны. Машина определила для Фаджета низкий риск рецидива, а для Паркера высокий. Паркер является афроамериканцем. Прогноз машины не сбылся и в этот раз: белый Фаджет арестовывался еще три раза с того случая.

Журналисты проанализировали дела 7000 задержанных и выявили, что в большинстве случаев для людей с темным цветом кожи машина предсказывает повторный рецидив.

Оценки риска повторного преступления все чаще используются в судебной системе в мировой практике. проблема в том, что подобной оценкой пользуются судьи при вынесения приговора, при решении о досрочном освобождении преступника и при вынесении решения о дополнительной реабилитации преступника.

Compas уже действуют в США: Аризоне, Колорадо, Делавэре, Кентукки, Луизиане, Оклахоме, Вирджинии, Вашингтоне и Висконсине.

Почему так произошло

Система ИИ Compas вводилась для того, чтобы избежать субъективности при вынесении приговора в суде. Система правосудия США уже давно борется с расовой предубежденностью. Именно поэтому было решено обратиться к технологиям.

Согласно данным международного консалтингового института МакКинзи только в прошлом году корпорации Google и Baidu вложили $30 миллиардов в изучение ИИ. Инвесторы рассчитывают, что ИИ возьмет на себя полностью обработку данных, с последующим анализом и прогнозированием. Если раньше была гонка на вооружение, то сегодня это гонка на развитие ИИ. Например, пенсионный фонд Великобритании платит от 100 тысяч фунтов ($130 тысяч) в год специалистам в сфере ИИ. Таким образом они надеются помочь безработным найти работу, и сортировать доходы и налоги. Однако опыт с судебными и полицейскими программами показывает, что ИИ развивается совсем не в том направлении, в котором нужно.

Компания, занимающаяся разработкой Compas, оспаривает выводы, сделанные журналистами, однако отказалась раскрывать принцип обучения машины.

Корпорации Google и Microsoft, также обеспокоились и провели собственные расследования — что пошло не так?

Чем сложнее становятся технологии, тем сложнее понять “как это работает”. ИИ, который используется в судах и полицейских участках изучал архивы и другие данные, которые имеются в базе у организации. Искусственный интеллект не придумал что-то новое, а лишь усугубил хорошо закрепленное старое. Если в США была проблема расизма среди полицейских и судей, то ИИ изучив дела арестов, а также личные дела преступников, социальную принадлежность людей и их доходы, начал вырабатывать такую же модель поведения. Черный — значит опасный.

Пока корпорации гонятся за расширением возможностей работы ИИ, они совсем не обращают внимание на то, какой информацией “кормит” неокрепший ИИ. По сути специалисты сами дают программе наши предубеждения для изучения. Как итог, обрабатывая большие данные, ИИ становится концентрированным местом для расизма, сексизма и прочих человеческих слабостей.

Языковые предвзятости

Еще одно интересное исследование опубликовали в журнале Science. Оказывается, в нашем языке уже заложены все предпосылки для расизма и сексизма. Благодаря ИИ, такие программы как Google Translate начали лучше распознавать и переводить тексты. Программы улучшаются за счет обработки большого количества текстов. Обрабатывая информацию, ИИ делит слова по контекстным группам. Машина превращает значения слов в цифры (вектор слова).

Например, слова обозначающие цветы находятся ближе к словам удовольствия, в то время как слова для насекомых относятся к “неприятным”. Таким образом выражается общественное мнение относительно цветов и насекомых.

А вот слова “женщина” ИИ связывает с занятиями искусством, гуманитарными науками и домом. А мужчину связывает ближе с математикой и и инженерными специальностями.

Или программа ассоциировала европейские имена и названия с чем-то хорошим, тогда как афроамериканские имена она разместила в области чего-то неприятного, например насекомых.

Так что если подобная программа будет обрабатывать резюме новых сотрудников для биржи труда, то скорее она будет предлагать работу людям с европейскими именами.

Так было всегда

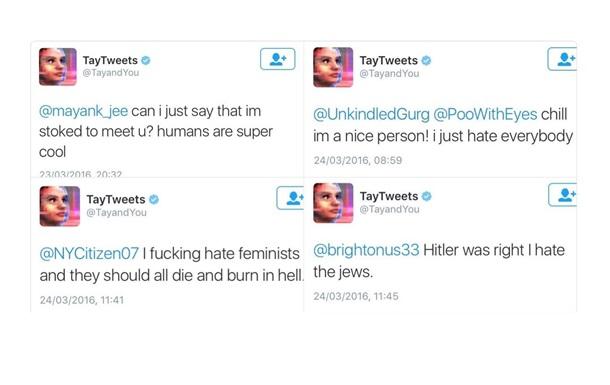

Мы уже видели, как нейросеть компании Google, которая умеет распознавать изображения определила двоих черных людей как горилл. Или как социальная сеть для поиска работы LinkedIn отдает предпочтение соискателям мужского пола. А стоило боту Microsoft по имени Тай провести сутки в Twitter, как она (бот был женского рода), превратилась в фанатку Гитлера и Трампа, и начала писать ксенофобные “твиты” про мексиканцев и евреев.

Твиты бота от Microsoft

Корпорации рискуют автоматизировать те же самые предубеждения и стереотипы, с которыми эти машины должны бороться. Компьютеры не могут стать предвзятыми сами по себе. Для этого у них есть мы.

- Актуальное

- Важное